AI ถูกพัฒนาและใช้งานอย่างก้าวหน้าในด้านสุขภาพ, ฟินเทค, อี-คอมเมิร์ซ และผลิตภัณฑ์ต่างๆ เช่น โทรศัพท์มือถือ AI หรือ Rabbit R1 โดย AI เหล่านี้พึ่งพา LLM และ LAM เพื่อประสิทธิภาพสูงสุด ใน AI Data Center จึงต้องการ AI Server, สวิตช์ ประสิทธิภาพสูง, Fiber Optic Transceivers, และสายเคเบิลที่ทันสมัย

การเปลี่ยนจากระบบเครือข่ายแบบดั้งเดิมไปสู่เครือข่ายที่ขับเคลื่อนด้วย AI เป็นการพัฒนาที่เปลี่ยนแปลงรูปแบบการทำงานของเครือข่ายในคลัสเตอร์ AI/ML ตัวชี้วัดที่สำคัญที่สุดคือ Job Completion Time - JCT

วิธีการทำให้ JCT (Job Completion Time) ดียิ่งขึ้น

1. ลด Latency: ใช้การเชื่อมต่อที่มีแบนด์วิธสูงและเครือข่ายที่มี Latency ต่ำ

2. ประมวลผลแบบขนาน: ใช้โปรเซสเซอร์และ GPU หลายตัวในการดำเนินงานพร้อมกัน

3. ติดตามประสิทธิภาพ: มีระบบติดตามจากภายนอก (telemetry) รองรับการตรวจสอบและปรับปรุงกระบวนการ

4. ทำงานอัตโนมัติ: ปรับปรุงกระบวนการด้วยการทำงานอัตโนมัติเพื่อลดความล่าช้า

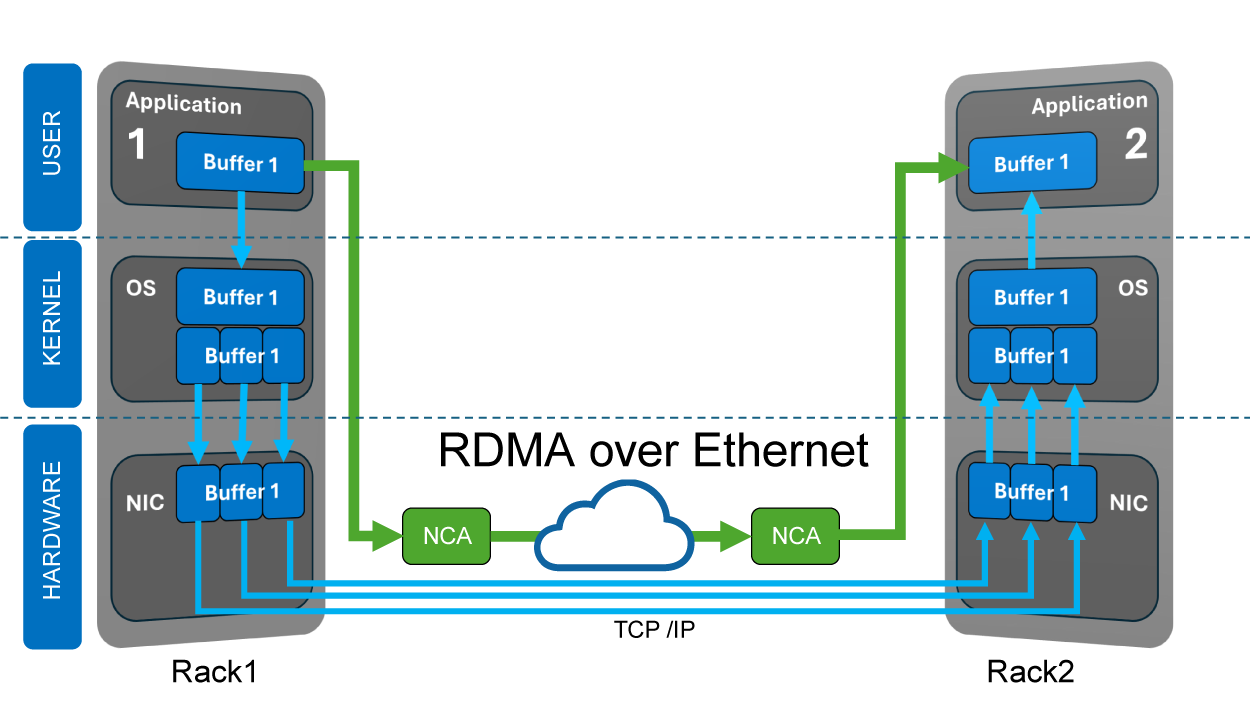

What is RoCE

เนื่องจากการส่งสัญญาณโดยไม่มีข้อมูลสูญหาย(Lossless Transmission) นั้นเป็นเรื่องสำคัญ RoCE (RDMA over Converged Ethernet) จึงมีบทบาทสำคัญอย่างมากในเครือข่าย AI โดยทำหน้าที่เป็นควบคุมอัตราการส่งข้อมูลและการจราจร

RDMA (Remote Direct Memory Access) เป็นเทคโนโลยีที่ช่วยให้การถ่ายโอนข้อมูลระหว่างหน่วยความจำและอุปกรณ์ภายนอก หรือจากหน่วยความจำสู่หน่วยความจำได้ โดยไม่ใช้ทรัพยากรของ CPU หรือ OS

การใช้ RDMA บน Ethernet หมายถึงผู้ส่งเข้าถึงหน่วยความจำของ NIC โดยตรงเพื่อลดความหน่วงเวลาและเพิ่มอัตราการส่งข้อมูล

PFC (Priority-based Flow Control) และ ECN (Explicit Congestion Notification) ในเครือข่ายช่วยให้การส่งข้อมูลแบบไม่มีการสูญเสียและหลีกเลี่ยงการติดขัด โดยการรวมกันของ PFC และ ECN เป็น DCQCN (Data Center Quantized Congestion Notification) ซึ่งเป็นโซลูชันการจัดการความแออัดที่มีประสิทธิภาพสูงสุดในเครือข่าย AI โดย DCQCN เป็นอัลกอริธึมการควบคุมความแออัดที่ใช้มากที่สุดในเครือข่าย RoCEv2

What is a GPU

GPU (Graphics Processing Unit) ถูกออกแบบมาเพื่อเร่งความเร็วกราฟิกคอมพิวเตอร์และการประมวลผลพิกเซลสำหรับภาพ ปัจจุบันนักวิทยาศาสตร์พบว่า GPU มีประสิทธิภาพสูงในด้านวิทยาศาสตร์ข้อมูลและการวิเคราะห์ภาพ จึงถูกนำไปใช้ในหลายสาขา รวมถึง AI และ ML (Machine Learning) ทำให้ GPU เป็นที่รู้จักในชื่อ GPGPU (General-Purpose computing on Graphics Processing Unit) เมื่อ GPU ทำงานร่วมกับ CPU จะช่วยเร่งกระบวนการทำงานและปลดปล่อยพลังของ AI

SONIC

Edge-Core นำเสนอ NOS สำหรับสวิตช์ AI ที่เรียกว่า SONiC ซึ่งรองรับแพลตฟอร์มสวิตช์หลากหลาย โดยมี Switch Abstraction Interface (SAI) ตั้งแต่ 1G ถึง 800G รองรับตั้งแต่ Leaf Switch, Spine Switch จนถึงระดับ Super Spine Switch

SONiC ที่มีความหลากหลายช่วยสนับสนุนการตรวจสอบและการจัดการ telemetry โดยเพิ่มประสิทธิภาพการส่งข้อมูลผ่านการเชื่อมต่อที่ไม่มีการสูญหายข้อมูลและการกระจายโหลด (Load Balancing) ทั้งนี้เพื่อลดความแออัดและเพิ่มประสิทธิภาพการทำงาน

นอกจากนี้ Edge-Core ยังมีบริการและการสนับสนุนแบบครบวงจรสำหรับ SONiC ในทุกขั้นตอน ตั้งแต่บริการก่อนการขายไปจนถึงหลังการขาย

Read more about SONIC